利用 GPU 加速人工智能:新型计算模式

利用 GPU 加速人工智能:新型计算模式

纽约大学本周有一场探讨 “人工智能的未来” 的年度座谈会,Yann LeCun 邀请NVIDIA 联合创始人兼首席执行官黄仁勋 (Jen-Hsun Huang)先生在座谈会上发言。这场完美的盛会聚集了人工智能领域中的诸多翘楚以探讨人工智能的发展现状以及不断取得的进展。以下为黄仁勋先生的发言主题,即为什么说深度学习是一种需要新型计算模式的全新软件模式;为什么人工智能研究人员采用 GPU 加速的计算模式;随着这种模式迅速流行,NVIDIA 为推动人工智能的进步正在开展哪些工作。以及为什么人工智能经过这么多年的发展之后才得以腾飞。

重大变革

自从我们设计计算机以来,人工智能一直是我们研发工作的终极前沿。在过去五十年里,打造能够像人类一样感知世界、理解人类语言、从例子中学习的智能机器一直是计算机科学家的毕生工作。然而,现代人工智能 (即深度学习) 的重大变革是由下列因素相结合所促成的:Yann LeCun 的卷积神经网络、Geoff Hinton 的反向传播、随机梯度下降训练法以及吴恩达大规模利用 GPU 来加速深度神经网络 (DNN) 的做法。

同时,NVIDIA 正忙于推动 GPU 加速型计算的发展。GPU 加速型计算是一种新型计算模式,它利用大规模并行图形处理器来加速那些具备并行特点的应用程序。科学家和研究人员转而采用 GPU 来执行分子级模拟以确定救命药物的有效性、以 3D 图形形式呈现我们的器官 (利用少量 CT 扫描来重建图像)、或者运行银河级模拟以发现支配我们宇宙运行的定律。一名利用我们的 GPU 运行量子色动力学模拟的研究人员曾对我说:“多亏了 NVIDIA 的成果,我现在能够在我的有生之年完成我毕生想要实现的工作。”这让人们获益良多。让人们拥有打造美好未来的能力一直是我们的使命。NVIDIA GPU 让超级计算实现了大众化,研究人员现已发现 GPU 强大的处理性能。

2011 年,人工智能研究人员发现了 NVIDIA GPU。当时谷歌大脑 (Google Brain) 项目刚刚取得了惊人的成果,它通过观看 YouTube 上的电影学会了识别猫与人类。但是它需要使用谷歌一家大型数据中心内的 2,000 颗服务器 CPU。这些 CPU 的运行和散热能耗巨大。很少有人拥有这种规模的计算机。NVIDIA 及其 GPU 出现在人们的视野中。NVIDIA 研究院的 Bryan Catanzaro 与斯坦福大学的吴恩达团队展开合作,将 GPU 应用于深度学习。事实表明,12 颗 NVIDIA GPU 可以提供相当于 2,000 颗 CPU 的深度学习性能。纽约大学、多伦多大学以及瑞士人工智能实验室的研究人员纷纷在 GPU 上加速其深度神经网络 (DNN)。此后,大家竞竞相效法。

深度学习创造奇迹

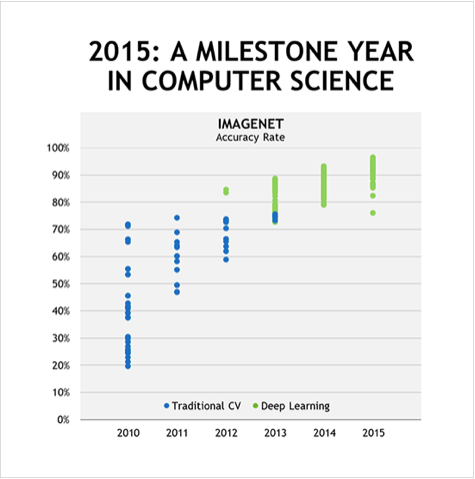

多伦多大学的 Alex Krizhevsky 在 2012 年 ImageNet 计算机图形识别大赛中胜出。(1) Krizhevsky 以大比分击败了计算机视觉专家所编写的人工软件。Krizhevsky 及其团队并未编写计算机视觉程序代码。相反,通过利用深度学习,他们的计算机自己学会了识别图像。他们设计了一个名为 AlexNet 的神经网络并使用 100 万幅实例图像对其进行训练,训练过程需要在 NVIDIA GPU 上运行数万亿次数学运算。Krizhevksy 的 AlexNet 成功击败了最好的人造软件。

人工智能竞赛就此开始。截至 2015 年,人们又实现了一个重大的里程碑。

利用深度学习,谷歌和微软双双击败了 ImageNet 挑战赛中的人类最好成绩。(2,3) 不是人造程序,而是人类。此后不久,微软与中国科学技术大学发布了一款深度神经网络,该网络取得了大学研究生级别的 IQ 测试分数。(4) 随后百度宣布发布了一款名为深度语音 2 (Deep Speech 2) 的深度学习系统,该系统利用单一算法学会了英语和汉语。(5) 2015 年 ImageNet 大赛中所有的最好成绩均基于深度学习、均在 GPU 加速的深度神经网络上运行,其中许多击败了人类的精度水平。

2012 年,深度学习击败了人造软件。截至 2015 年,深度学习已经实现了“超人级”的感知能力。

用于全新软件模式的新型计算平台

计算机程序包含诸多命令,这些命令大多是按顺序执行的。深度学习是一种全新的软件模式,其中数十亿个软件神经元和数万亿个连接被并行地训练。运行 DNN 算法并从实例中学习,从本质上来说,该计算机正在编写自己的软件。这种大不相同的软件模式需要新型计算机平台才能高效运行。加速型计算是一种理想的方式,而 GPU 则是理想的处理器。如《自然》杂志最近所指出的一样,深度学习领域中的早期成果归功于“高速图形处理器 (GPU) 的出现,这些图形处理器便于编程,让研究人员能够将训练网络的速度提升 10 或 20 倍。”(6) 性能、编程效率以及开放性是打造一款新型计算平台的关键因素。

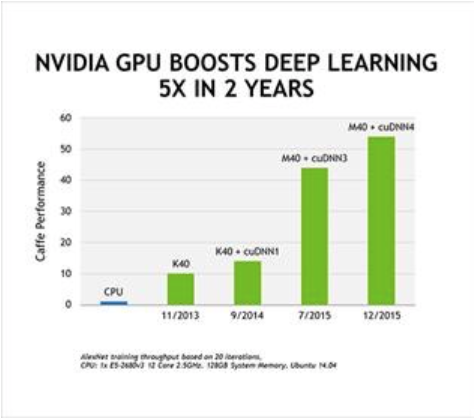

性能。 NVIDIA GPU 天生擅长处理并行任务,可令 DNN 的速度提升 10-20 倍,从而能够将反复训练耗时从数周缩短至数天,并且我们没有就此止步。通过与人工智能开发者展开合作,我们不断改善我们的 GPU 设计、系统架构、编译器以及算法并在短短的三年里使训练深度神经网络的速度提升了 50 倍,这一发展速度远比摩尔定律快多了。我们预计,在未来几年里训练速度将再提升 10 倍。

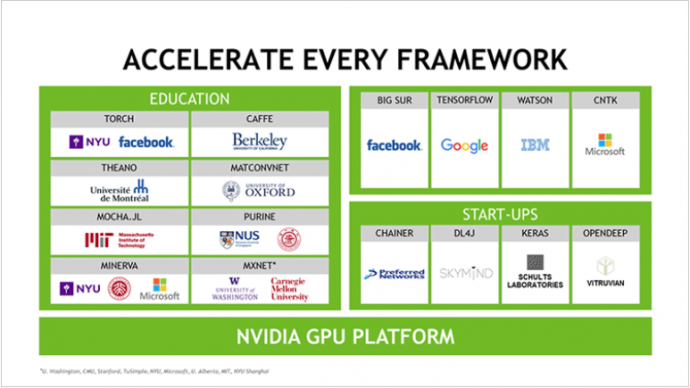

可编程性。 人工智能创新发展迅猛。易于编程和开发者效率是至关重要的。NVIDIA CUDA 平台的可编程性和丰富度让研究人员能够快速创新,打造全新配置的 CNN、DNN、深度感知网络、RNN、LSTM 以及强化学习网络。

可及性。 开发者想要在任何地方进行开发或部署。NVIDIA GPU 在世界各地每一家电脑 OEM 厂商处均可以买到;在台式机、笔记本、服务器或超级计算机中均有它的身影;在 Amazon、IBM 以及微软等公司的云端均可以看到它。从互联网公司到研究机构再到初创公司,各大人工智能开发框架均支持 NVIDIA GPU 加速。无论用户青睐哪一种人工智能开发系统,该系统都可以通过 GPU 加速来更快地运行。我们还为各种外形尺寸的计算设备开发了 GPU,这样 DNN 便能够成就各种类型的智能机器。GeForce针对个人电脑,Tesla针对云和超级计算机,Jetson 针对机器人和无人机,而 DRIVE PX 针对汽车。所有这些 GPU 均共用同一种架构,均可加速深度学习。

各行各业均需要智能

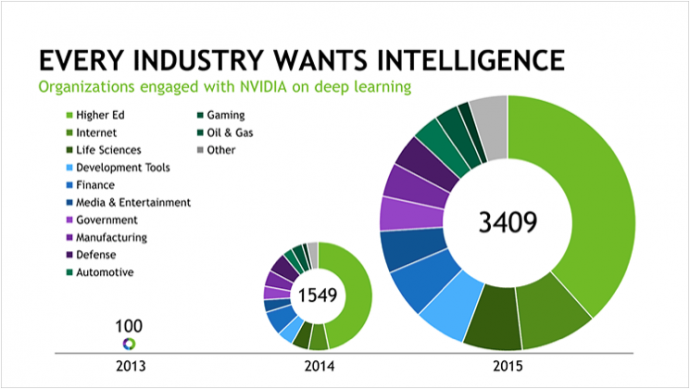

百度、谷歌、Facebook、微软是首批将 NVIDIA GPU 应用于深度学习的企业。这种人工智能技术可对你说出的话做出响应、可将语音或文本翻译成另一种语言、可识别图像并自动为图像添加标签、可根据我们每个人的喜好和兴趣推荐新闻递送、娱乐以及产品。初创企业和老牌企业现在均面临着利用人工智能打造新产品和新服务或者利用人工智能改善其企业运营。在短短两年里,与 NVIDIA 在深度学习方面展开合作的企业便激增了近 35 倍,增至 3,400 多家企业。医疗、生命科学、能源、金融服务、汽车、制造业以及娱乐业等行业均将得益于海量数据的分析。而且,随着 Facebook、谷歌以及微软将其深度学习平台开放给所有人使用,基于人工智能的应用将会迅速蔓延。鉴于这一趋势,《连线》杂志最近发表文章预测了 “GPU 的崛起”。

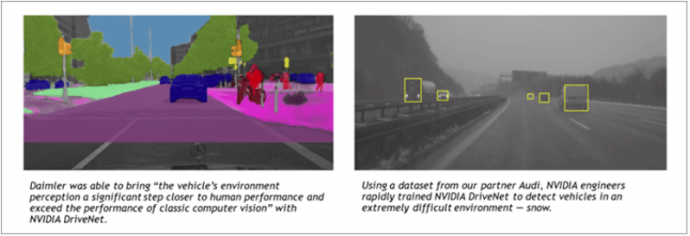

自动驾驶汽车。 不论是以超人般的自动驾驶仪来增强人类能力,还是掀起个人出行服务的革命,亦或是减少人们在城市内大肆扩建停车场的需求,自动驾驶汽车都有可能带来巨大的社会效益。驾驶是一项复杂的任务,意外的事情总会不期而至。例如冻雨会将公路变成滑冰场,通往目的地的公路会被关闭,儿童会从车前跑过。你无法通过编写软件来预测自动驾驶汽车可能遭遇的每一种情形。这就是深度学习的价值所在,它可以学习、适应和改良。我们正在为自动驾驶汽车打造一款名为 NVIDIA DRIVE PX 的端到端深度学习平台,端到端指的是从训练系统到车载人工智能电脑。这些成果非常激动人心。将来,超人般的电脑自动驾驶仪和无人驾驶通勤车将不再是科幻场景。

机器人。 FANUC 是一家领先的工业机器人制造商,这家公司最近展示了一款流水线机器人,该机器人可学会从箱子中“挑出”随机朝向的物体。基于 GPU 的机器人通过试验和误差来完成学习过程。这种深度学习技术由 Preferred Networks 所开发,这家企业最近登上了华尔街日报,文章标题为“日本想要利用人工智能重振科技”。

医疗和生命科学。 深度基因组学正在利用基于 GPU 的深度学习来了解遗传变异是如何导致疾病的。Arterys 利用基于 GPU 的深度学习来加速医学影像分析。其技术将被应用于 GE 医疗的 MRI 机器当中以帮助诊断心脏病。Enlitic 正在利用深度学习来分析医学影像以识别肿瘤、肉眼几乎看不到的骨折以及其它病症。

这样的例子有很多,几乎有数千个。

利用 GPU 加速人工智能:新型计算模式

深度学习领域中的突破引发了人工智能革命。基于人工智能深度神经网络的机器可解决人类程序员无法解决的复杂难题。这些机器可以从数据中学习,然后在使用中实现改良。即便用户不是程序员,也能够训练同一种 DNN 来解决新问题。其发展十分迅猛,采纳程度也不断激增。我们坚信,它对社会带来的影响也会迅猛增长。KPMG 最近的一项研究预计,电脑化的驾驶员辅助技术将有助于在 20 年内使车祸减少 80%,相当于每年拯救近 100 万人的生命。深度学习人工智能将是这一领域中的基础性技术。

它对计算机行业带来的影响也将会迅猛增长。深度学习是一种全新的软件模式。因此我们需要一种新型计算平台来运行它,即一种可高效执行程序员编码指令、可大规模训练深度神经网络的架构。我们坚信,GPU 加速型计算将是实现这一切的必由之路。Popular Science杂志 最近将 GPU 称为“现代人工智能的生力军”,我们也是这样认为的。

参考文献

A. Krizhevsky、I. Sutskever、G. Hinton。利用深度卷积神经网络执行 ImageNet 图像分类。摘自 神经信息处理系统的发展进步 25 1090–1098 (2012)。

K. He、X. Zhang、S. Ren、J. Sun。深入探究纠正程序:在 ImageNet 图像分类上超越人类水平。 arXiv:1502.01852 [cs] (2015)。

S. Ioffe、C. Szegedy。批量标准化:通过减少内部协变量变化来加速深度网络训练。摘自 机器学习国际大会 (ICML) 448–456 (2015)。

H. Wang、B. Gao、J. Bian、F. Tian、T.Y. Liu。通过基于知识的字词嵌入来在 IQ 测试中解决语言理解问题。 arXiv:1505.07909 [cs.CL] (2015)。

D. Amodei、R. Anubhai、E. Battenberg、C. Case、J. Casper、B. Catanzaro、J. Chen、M. Chrzanowski、A. Coates、G. Diamos、E. Elsen、J. Engel、L. Fan、C. Fougner、T. Han、A. Hannun、B. Jun、P. LeGresley、L. Lin、S. Narang、A. Ng、S. Ozair、R. Prenger、J. Raiman、S. Satheesh、D. Seetapun、S. Sengupta、Y. Wang、Z. Wang、C. Wang、B. Xiao、D. Yogatama、J. Zhan、Z. Zhu。“深度语音 2:英语和汉语端到端语音识别” arXiv 预印 arXiv:1512.02595 (2015)。

Y. LeCun、Y. Bengio、G. Hinton。深度学习 – 评论。《自然》杂志 (2015)。

转自NVIDIA官网

本文为作者 分享,影视工业网鼓励从业者分享原创内容,影视工业网不会对原创文章作任何编辑!如作者有特别标注,请按作者说明转载,如无说明,则转载此文章须经得作者同意,并请附上出处(影视工业网)及本页链接。原文链接 https://cinehello.com/stream/74850